Drones, cães robôs e por que você deveria usar máscara

Propagandeada como sinônimo de eficiência e modernização da segurança pública, a controversa tecnologia de reconhecimento facial pode oferecer instrumentos de perseguição política e ameaça à privacidade, além de reforçar uma lógica de controle social racista.

“Smart Dog” da Guarda Civil Metropolitana de São Paulo utilizado para reforçar a atuação das forças de segurança pública no carnaval deste ano. Reprodução/Foto: Ciete Silvério/SMSU

Por Mônica Guerra

Consolidado nas principais cidades do país por meio de contratos milionários entre o poder público e empresas estrangeiras, o uso de reconhecimento facial se intensifica em eventos com grandes aglomerações. Na grande São Paulo, uma das várias cidades que utilizarão o reconhecimento facial para monitorar o carnaval de 2025, as forças de segurança farão uso não só de 20 mil novas câmeras adquiridas através do programa Smart Sampa, mas também de drones e até mesmo de cães robôs. Propagandeada como sinônimo de eficiência e modernização da segurança pública, a controversa tecnologia pode oferecer instrumentos de perseguição política e ameaça à privacidade, além de reforçar uma lógica de controle social racista.

Desde 2011, com destaque a partir de 2019, vários estados do país começaram a implementar a tecnologia por meio de contratos fechados pelos Governos Estaduais junto a empresas do Brasil (Teltex e Oi), China (Huawei), Espanha (Iecisa) e Israel (Corsight e Cellebrite). Embora as justificativas formais se ancorem, principalmente, na identificação de suspeitos e desaparecidos, o objetivo central está na vigilância e no controle da população - especialmente de seus setores mais marginalizados – e no lucro das grandes empresas de tecnologia.

Funciona assim: os locais de grande fluxo da classe trabalhadora são monitorados por câmeras integradas ao sistema de segurança pública, chegando a ler 40 milhões de rostos por semestre, tendo como referência informações da SSP do Estado da Bahia. Depois de analisar determinados pontos do rosto (chamados pontos nodais), ou até mesmo o modo de caminhar, o algoritmo os compara com as informações disponibilizadas pelo banco de dados da Secretaria de Segurança Pública, podendo inclusive utilizar fotos publicadas em redes sociais e em outras plataformas não oficiais. A partir de 90% de semelhança, os sistemas emitem um alerta às autoridades, que realizam uma “análise humana” e direcionam policiais para a abordagem a fim de confirmar se realmente se trata do suspeito.

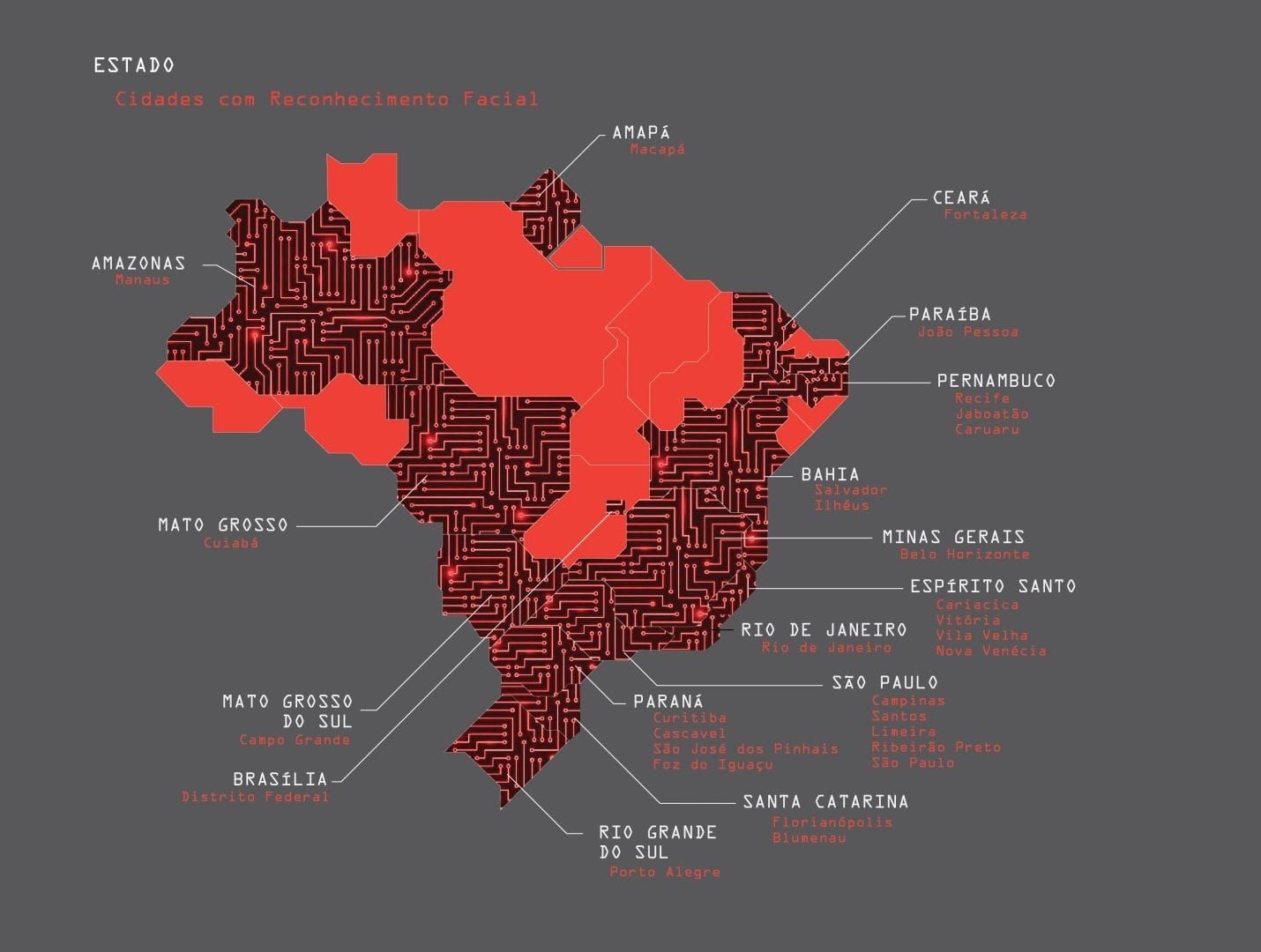

Reconhecimento facial vem sendo implementado no Brasil desde 2011. Infográfico elaborado pelo Instituto Igarapé (2019)

Com ou sem inteligência artificial, a intervenção da polícia segue seus procedimentos clássicos. As pessoas abordadas relatam humilhação e coerção. Trabalhadoras são constrangidas em seus locais de trabalho, chegando a sofrer racismo até mesmo em espaços de promoção da igualdade racial. No estado de Sergipe, ainda em 2023, uma auxiliar administrativa foi sucessivamente abordada enquanto tentava pular carnaval, chegando a urinar na própria roupa devido ao constrangimento. Já em abril do ano passado, um homem perdeu a final de um campeonato estadual e foi humilhado diante da torcida do Confiança ao ser confundido. Após os casos, o Governo do Estado de Sergipe decidiu suspender o uso da tecnologia temporariamente.

Os episódios não são raros. Com base em um discurso de avanço técnico e racionalidade científica, governos como o de Rui Costa (PT-BA) chegaram a investir quase R$ 700 milhões em tecnologias que alcançaram até 92% de taxa de erro em um único evento. Acima de tudo, na verdade, trata-se de uma tecnologia de reconhecimento racial. As maiores taxas de imprecisão do algoritmo recaem sobre a população negra e as mulheres, tendendo a agravar outros indicadores de violência racial e de gênero já alarmantes – como no caso do encarceramento, no qual 64% dos detentos são negros e quase 30% sequer foi condenado.

Identificado como suspeito pela Polícia Civil do Ceará, até o ator Michael B. Jordan poderia ser indiciado como assassino. Nos bancos de dados das Secretarias de Segurança Pública, do Sistema de Cadastro de Mandados de Prisão da Polícia Civil e do Banco Nacional de Mandados de Prisão do Conselho Nacional de Justiça, não faltam inocentes e cadastros irregulares. A desatualização e erro de informações inseridas nas bases de dados previamente podem conduzir a detenções ilegais, como foi o caso de duas das primeiras quatro pessoas presas no Rio de Janeiro no ano passado durante a implementação do sistema de reconhecimento facial comprado pelo Governo do Estado por R$ 18 milhões.

O racismo algorítmico que orienta o desenvolvimento desses programas serve para controlar uma massa de trabalhadores considerados “perigosos” para a burguesia. Além de acentuar o risco de prisões injustas, também intensifica a vigilância sobre grupos marginalizados, direcionando recursos e aumentando a violência policial em comunidades pobres e periféricas, consideradas de “alto risco”. Esse monitoramento preditivo e o enviesamento de decisões judiciais influenciadas por sistemas informacionais carregados de estereótipos potencializam discriminações e injustiças, perpetuando e agravando a violência e o racismo.

Privacidade e economia de dados

A Lei Geral de Proteção de Dados (LGPD) se fundamenta em sete princípios, entre eles estão os direitos à privacidade, à liberdade de expressão, à inviolabilidade da intimidade e aos direitos humanos. Para garanti-los, distingue dado pessoal de dado pessoal sensível, este último relacionado à origem étnico-racial, religião, posição política, saúde, vida sexual, bem como dado genético ou biométrico. O reconhecimento facial, por sua vez, é uma aplicação das informações de biometria facial, podendo envolver o cruzamento com outros dados.

Embora a legislação ainda seja insuficiente diante do rápido desenvolvimento de novas tecnologias baseadas em inteligência artificial (IA) e aprendizado de máquina (machine learning), a LGPD estabelece hipóteses para o tratamento de dados considerados sensíveis, exigindo consentimento explícito do titular para a maioria dos casos.

Essas limitações não impediram a compra de softwares invasivos pelo Estado brasileiro. Licenciado pelo Ministério da Justiça em 2023, o Clearview, de empresa estadunidense de mesmo nome, oferece um sistema de reconhecimento facial utilizando dados raspados em toda a internet, inclusive em redes sociais e de países nos quais não possui licença para operar. Com um rosto suspeito e o software em mãos, basta realizar uma busca para encontrar informações sobre praticamente qualquer um.

Banido de diversos países europeus sob os mesmos argumentos que asseguram a proteção de dados sensíveis no Brasil, o Clearview enfrenta opositores até mesmo nas big techs. Ele foi encomendado ainda durante o Governo Bolsonaro para ser utilizado no Projeto Excel, que tem como objetivo, segundo a Portaria que o protocola, “a criação de uma base de dados constituída por dados extraídos por ferramentas próprias e compartilhados com a Diretoria de Inteligência [da Secretaria de Operações Integradas do Ministério da Justiça (Seopi)] possibilitando a produção de conhecimento qualificado, oportuno e eficiente e que resulte em efetivas ações policiais em face das organizações criminosas”.

Diretoria esta que, à época, era dirigida por Marília Alencar, uma das 33 pessoas acusadas pela Procuradoria Geral da República (PGR) de envolvimento na tentativa de golpe bolsonarista de 2022. Dois meses após assinar o pedido de compra da tecnologia que levaria o Clearview às mãos do Ministério da Justiça e do Senado, Alencar participou ativamente da organização das blitzes da Polícia Rodoviária Federal (PRF) durante o segundo turno eleitoral.

Quem assina a criação do Projeto Excel, que deu à Seopi o acesso aos dados de todos os celulares apreendidos pelas Polícias Civis, é Jeferson Lisbôa Gimenes, delegado da Polícia Civil do Distrito Federal que comandava a Secretaria durante a produção do dossiê que mapeou policiais antifascistas e opositores do Governo Bolsonaro em 2020.

Granadas biodegradáveis para um futuro sustentável

Cães robôs com reconhecimento facial são apenas um pedaço muito pequeno dessa distopia cibernética. A venda e a manipulação de megadados recheados de informações sensíveis da população de diversos países já adquiriu contornos muito perigosos. Em São Paulo, a OpenIA e a Tools for Humanity continuam comprando o escaneamento de íris brasileiras a preço irrisório, sem sequer justificar adequadamente para quais fins.

Em larga escala, a concentração de dados sensíveis da população mundial sob domínio das big techs é uma arma de guerra pronta para ser utilizada. A combinação de sistemas de reconhecimento facial e de armamentos de enorme potencial destrutivo já é uma realidade em Gaza.

O que há oito anos talvez não passasse de uma ficção científica para a imensa maioria de nós, para as grandes empresas do setor provavelmente já se tratasse de um protótipo. Na ocasião da Convenção das Nações Unidas sobre Armas Convencionais (Genebra, 2017), o professor Stuart Russell, da Universidade da Califórnia (Berkeley), lançou junto ao Future of Life Institute um curta-metragem de sete minutos contra armas autônomas.

O vídeo ilustra um futuro no qual pequenos drones programados com inteligência artificial são capazes de perseguir e assassinar alvos com alta precisão. Influenciada pela Doutrina da Guerra ao Terror, a campanha dá ênfase aos problemas decorrentes do uso deste tipo de armamento por civis ou grupos paramilitares difíceis de identificar e combater. Entretanto, como já demonstramos, “armas nas mãos certas” significam apenas lucros astronômicos para a indústria da guerra e mais violência para as e os trabalhadores.

Menos de uma década depois, os drones que sobrevoam o carnaval de Belo Horizonte também são capazes de localizar e identificar seus alvos – mas, ao menos por enquanto, ainda não estão munidos de explosivos. Basta alinhar alguns protocolos a uma longa tradição de irregularidades que logo estaremos discutindo a ética no uso destes drones, combinados com armamento automatizado, pelo Batalhão de Operações de Especiais durante intervenções nas favelas do Rio de Janeiro. Quando chegar esse dia, contrariando as estatísticas concretas, eles dirão que isso reduzirá o índice de assassinato de inocentes.

Enquanto isso, as redes sociais estão fascinadas com os robôs que passeiam sozinhos pela orla em Niterói ou na Avenida Paulista. A inovação tecnológica que impressiona – talvez pelo antigo desejo de extinguir o trabalho e, assim, os próprios trabalhadores –, é na verdade propaganda projetada para transformar em paranoia e delírio qualquer reivindicação séria sobre privacidade, autodeterminação informativa e, precisamente, defesa nacional e segurança pública.

Como toda produção de tecnologias é e sempre será resultado do trabalho intelectual e físico de seres humanos, todo esse desenvolvimento também custa caro em termos de exploração das pessoas e do planeta Terra. Para a Condor, a solução está em desenvolver granadas biodegradáveis seguindo “os protocolos mais modernos da indústria sustentável”, como anunciaram em 2023 durante a LAAD Defence & Security, feira de tecnologias militares que aconteceu no Rio de Janeiro.

Para as e os trabalhadores, a solução é menos fácil e mais custosa. Depender do avanço de propostas legislativas como o marco regulatório da inteligência artificial ou de debates cínicos e intermináveis nas Nações Unidas não nos levará a adiar o fim do mundo - seja pelas armas, seja pelo colapso ambiental. Embora a luta contra o domínio das big techs e a campanha contra o uso irrestrito da IA na guerra e na segurança pública sejam urgentes, será apenas por meio de um processo revolucionário que será possível fazer frente à extinção.

Em que pese a magnitude das tarefas envolvidas, o caminho, ao menos, é um só. Envolve o reconhecimento das tecnologias de informação como campo interdisciplinar, com destaque evidente para trabalhadores da computação, e o posicionamento de gente disposta em todos os lugares nos quais pudermos brigar por uma sociedade na qual a maioria da classe trabalhadora decida o destino das inovações produzidas pela humanidade.

Que o carnaval de 2025 seja também palco de expressão artística e política da luta por um futuro socialista para o Brasil.